语言模型越来越强大如何在不扩大规模的情况下提高模型性能AI想出了一个强强联合的好主意

最近几年来,语言模型在自然语言处理的研究中变得越来越突出,并且在实践中变得越来越有影响力一般来说,在一系列的自然语言处理任务中,扩大模型的规模已经被证明可以提高性能

可是,扩大模型规模的挑战也是显而易见的:训练新的和更大的模型需要大量的计算资源此外,新模型往往是从零开始训练的,不能利用以前模型的训练权重

为了解决这个问题,谷歌研究人员探索了两种互补的方法,在不消耗大量额外计算资源的情况下,极大地提高了现有语言模型的性能。

首先,在文章以0.1%的额外计算转移缩放定律中,研究人员介绍了UL2R,这是一个轻量级的第二阶段预训练模型,它使用了一个混合的enoisers目标UL2R提升了一系列任务的性能,甚至在之前性能近乎随机的任务上释放了爆发性能

此外,在缩放指令—微调语言模型中,讨论了在以指令作为措辞的数据集上微调语言模型的问题这个过程被称为果馅饼该方法不仅提高了性能,而且提高了语言模型对用户输入的可用性

最后,Flan和UL2R可以作为互补技术结合在一个名为Flan—U—PaLM 540B的模型中,该模型在一系列具有挑战性的评估基准中比未经调整的PaLM 540B模型高出10%。

UL2R的培训

传统上,大多数语言模型都是在因果语言建模目标上进行预训练,以便模型可以预测序列中的下一个单词或去噪目标,其中模型学习从受损的单词序列中恢复原句。

虽然语言建模目标之间存在一些权衡,即因果关系的语言模型在长句生成中表现更好,而去噪目标训练的语言模型在微调中表现更好,但在之前的工作中,研究人员已经表明,包括这两个目标的混合enoisers目标在两种情况下都能取得更好的性能。

可是,从零开始用不同的目标预先训练一个大的语言模型在计算上是困难的因此,我们提出UL2修复,这是用UL2目标继续预训练的附加阶段,并且只需要相对少的计算

我们将UL2R应用于PaLM,并将由此产生的新语言模型称为U—PaLM。

在实证评估中,我们发现仅少量的UL2训练就能极大地改进模型。

例如,通过在PaLM 540B的中间检查点使用UL2R,可以达到PaLM 540B在最终检查点的性能,并且计算量是原来的两倍当然,将UL2R应用到最终的PaLM 540B检查点也会带来很大的提升

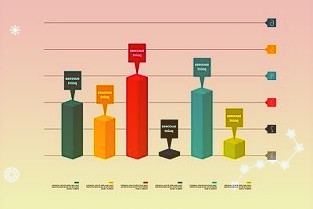

PaLM 540B和U—PaLM 540B在26个NLP基准上的计算和模型性能比较U—PaLM 540B继续训练PaLM,运算量非常小,但性能提升很大

使用UL2R的另一个优点是,它在某些任务上的性能比纯粹以因果语言建模为目标训练的模型好得多例如,许多大板凳任务都有所谓的新兴能力,即只有在足够大的语言模型中才有的能力

虽然发现新兴能力最常见的方法是通过扩大模型规模,但UL2R实际上可以在不扩大模型规模的情况下激发新兴能力。

例如,在大平台的导航任务中,测量模型的状态跟踪能力除了U—PaLM,所有型号的训练翻牌都不到10个23另一个例子是BIG—Bench的Snarks任务,该任务测量模型检测讽刺语言的能力

对于BIG—Bench的两种能力,展示了新兴的任务性能因为U—PaLM使用UL2R目标,所以它在较小的模型规模中实现了新兴性能

指令微调

在第二篇论文中,我们讨论了指令微调,这涉及到在一组NLP数据集上用指令作为措辞来微调LM。

在之前的工作中,我们将指令微调应用于62个NLP任务的137B参数模型,例如回答一个小问题,对电影中表达的情绪进行分类,或者将句子翻译成西班牙语。

在这项工作中,我们在1.8K以上的任务上微调了540B参数的语言模型此外,以前的工作只微调了少数例子或零例子的语言模型,但我们微调了两者的组合

我们还包括思维链微调数据,这使模型能够进行多步推理我们称我们的改进方法为Flan来微调语言模型

值得注意的是,即使在1.8K的任务上进行微调,与预训练相比,Flan也只需要很小的计算量。

在以指令形式表达的1.8K任务上微调语言模型,并在微调中不包括的新任务上评估模型分别对有/无实例和有/无思维链进行微调,使得模型可以在一系列评估场景中推广

本文对一系列语言模型进行了指令微调,旨在研究在扩大语言模型规模的同时增加微调任务数量的联合效应。

例如,对于类掌语言模型,它包括8B,62B和540B参数规范我们的模型在四个具有挑战性的基准评估标准上进行评估,发现扩展参数的数量和微调任务的数量可以提高在新任务上的性能,这是以前没有过的

将参数模型扩展到540B和使用1.8K的微调任务都可以提高性能上图的y轴是四个评估套件的归一化平均值

指令微调LM除了性能更好之外,还可以在推理时响应用户的指令,不需要少量的例子或提示这使得LM在一系列的输入中更方便用户例如,没有指令微调的LM有时会重复输入或无法遵循指令,但指令微调可以减轻这种错误

我们的指令微调语言模型Flan—PaLM比没有指令微调的PaLM模型对指令有更好的响应。

强强联手,实现1+1gt,2」

最后,我们表明UL2R和Flan可以结合起来训练Flan—U—PaLM模型。

因为Flan使用NLP任务的新数据,可以实现零指令跟踪,所以我们把Flan作为UL2R之后的第二选择。

我们再次对四个基准套件进行评测,发现Flan—U—PaLM模型要优于只有UL2R或者只有Flan的PaLM模型此外,当结合思维链和自我一致性时,Flan—U—PaLM在MMLU基准上取得了新的SOTA,得分为75.4%

与仅使用UL2R或仅使用Flan相比,将UL2R与Flan结合将带来最佳性能:四种评估试剂盒的归一化平均值。

总的来说,UL2R和Flan是两种互补的方法,用于改进预训练语言模型UL2R使用相同的数据来使LM适应去噪器的混合目标,而Flan使用超过1.8K NLP任务的训练数据来教会模型遵循指令

伴随着语言模型变得越来越大,UL2R和Flan等无需大量计算就能提高一般性能的技术可能会越来越有吸引力。

参考资料:

郑重声明:此文内容为本网站转载企业宣传资讯,目的在于传播更多信息,与本站立场无关。仅供读者参考,并请自行核实相关内容。

-

液化天然气槽罐车遭货车追尾发生泄漏多部门福建省南平市消防救援支队13日透露,12日14时左右,该支队指挥中心接到报警,称...

液化天然气槽罐车遭货车追尾发生泄漏多部门福建省南平市消防救援支队13日透露,12日14时左右,该支队指挥中心接到报警,称... -

180人星夜驰援!7小时筑起6公里“防疫180人星夜驰援!7小时筑起6公里“防疫长城”题:180人星夜驰援!7小时筑起6...

180人星夜驰援!7小时筑起6公里“防疫180人星夜驰援!7小时筑起6公里“防疫长城”题:180人星夜驰援!7小时筑起6... -

疫情下7人管好5000人“居委干部不要怕疫情下7人管好5000人“居委干部不要怕认错”题:疫情下7人管好5000人“居委...

疫情下7人管好5000人“居委干部不要怕疫情下7人管好5000人“居委干部不要怕认错”题:疫情下7人管好5000人“居委...

-

开完冠道,再开锐界plus,立刻想换车了!

2023-12-08 08:07

-

南京鼓楼融合改革实验区建设成果汇报会举行

2023-12-08 07:53

-

售12.98万元,外观动感,比亚迪宋ProDM-i冠

2023-12-08 06:06

-

湖北加速数字体育发展构建现代体育产业体系

2023-12-08 04:18

-

试驾深蓝SL03,底盘,隔音都升级,20万以内舍它其

2023-12-08 03:54

-

丰田卡罗拉:大受欢迎的家用明星,值得考虑

2023-12-08 02:18

-

25吨泰国冻鸡副产品从关累港口岸入境

2023-12-08 00:19

-

打造车、芯跨产业交流高端平台!2023全球汽车芯片创

2023-12-08 00:03

-

你以为买mpv车主都是40岁大叔其实90后也喜欢超大

2023-12-07 22:32

-

呵护儿童青少年眼健康华厦眼科在全国持续开展“启明行动

2023-12-07 20:29

-

新一代梅赛德斯-奔驰CLA四门轿跑车上市

2023-12-07 20:28

-

同样是搭载弗迪混动,蓝电E5却比宋Pro更亲民,你选

2023-12-07 18:42

-

预售22.98万起传祺ES9闪耀南京车展

2023-12-07 16:48

-

国家数据局:平台企业在支持创造就业等方面持续加大投资

2023-12-07 16:10

-

起亚K8发布,造型相当特别,有机会翻红?

2023-12-07 15:30